<configuration>

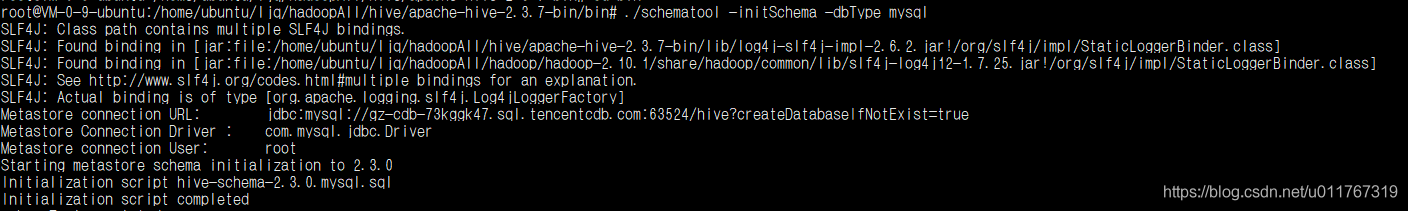

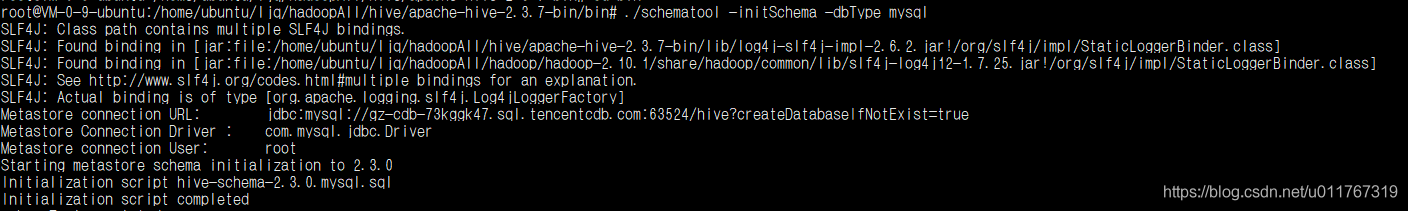

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://gz-cdb-73kggk47.sql.tencentcdb.com:63524/hive?createDatabaseIfNotExist=true</value>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>ccnfgame001</value>

</property>

</configuration>

把MySQL的JDBC驱动包复制到Hive的lib目录下(略,下载地址:https://dev.mysql.com/downloads/connector/j/)

(驱动包名为:mysql-connector-java-5.1.46-bin.jar)看自己数据库什么版本,就下载什么版本就行了

检查连接 在bin目录下运行以下代码

./schematool -initSchema -dbType mysql

hive 远程服务 (端口号10000) 启动方式 (Thrift服务)

bin/hive –service hiveserver2 &(&表示后台运行)

用java,python等程序实现通过jdbc等驱动的访问hive就用这种起动方式了,这个是程序员最需要的方式了

参考文章

安装spark

官网下载相应的包

scala

配置环境(一定要先配置好 hadoop的环境)

vim /etc/profile

#scala

export SCALA_HOME=/home/ubuntu/ljq/hadoopAll/spark/scala-2.12.12

export PATH=$PATH:$SCALA_HOME/bin

source /etc/profile

参考地址

cs