PRML 1.5 决策论

1.5.1 最小化错误分类率(Minimizing the misclassification rate)

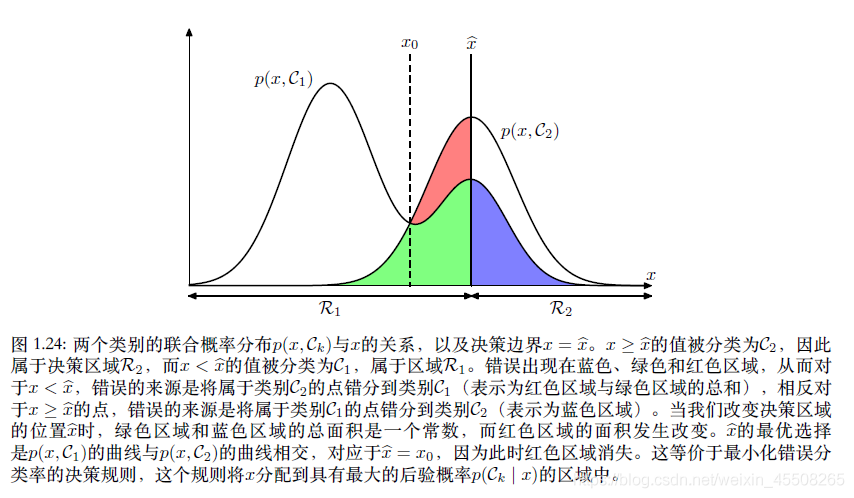

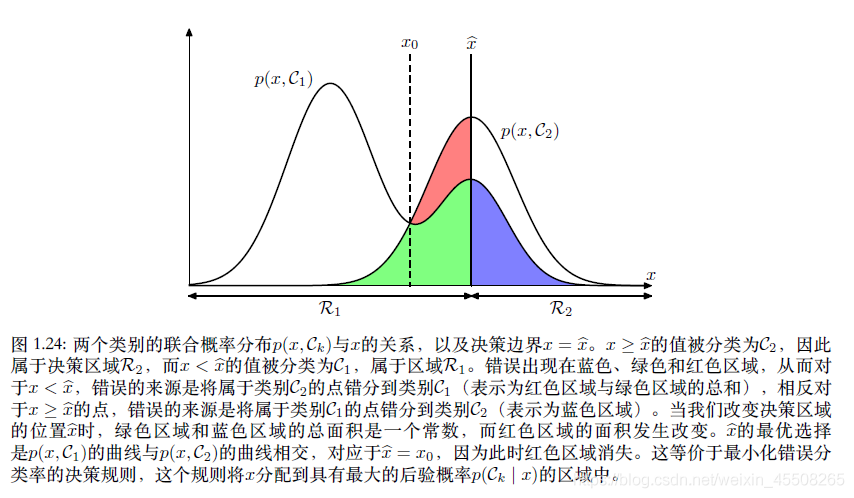

对监督学习中的分类问题来讲,我们需要一个“规则”,把每一个

x

x

x分到合适的类别中去。这个“规则”会把输入空间分成不同的区域,这种区域叫做决策区域(decision region),而决策区域的边界叫做决策边界或者叫决策面。如上图所示,如果我们将属于

C

1

C_1

C1?类的值分到了

C

2

C_2

C2?类中,那么我们就犯了一个错误。这种发生的概率如下:

p

(

m

i

s

t

a

k

e

)

=

p

(

x

∈

R

1

,

C

2

)

+

p

(

x

∈

R

2

,

C

1

)

=

∫

R

1

p

(

x

,

C

2

)

d

x

+

∫

R

2

p

(

x

,

C

1

)

d

x

p(mistake) = p(x\in R_1, C_2)+p(x\in R_2, C_1)=\int_{R_1}p(x,C_2)\mathrm{d} x+\int_{R_2}p(x,C_1)\mathrm{d} x

p(mistake)=p(x∈R1?,C2?)+p(x∈R2?,C1?)=∫R1??p(x,C2?)dx+∫R2??p(x,C1?)dx

我们当然希望将错误降到最小,即最小化

p

(

m

i

s

t

a

k

e

)

p(mistake)

p(mistake)。根据乘积规则,

p

(

x

,

C

k

)

=

p

(

C

k

∣

x

)

p

(

x

)

p(x, C_k)=p(C_k|x)p(x)

p(x,Ck?)=p(Ck?∣x)p(x)

对最小化

p

(

x

,

C

k

)

p(x, C_k)

p(x,Ck?),那么需要最小化

p

(

C

k

∣

x

)

p(C_k|x)

p(Ck?∣x)。

对于更?般的K类的情形,最大化正确率会稍微简单?些,即最大化下式

p

(

correct

)

=

∑

k

=

1

K

p

(

x

∈

R

k

,

C

k

)

=

∑

k

=

1

K

∫

R

k

p

(

x

,

C

k

)

dx

p ( \text{correct} ) =\sum_{k=1}^Kp ( \text{x}\in\mathcal{R}_k,\mathcal{C}_k ) =\sum_{k=1}^K\int_{\mathcal{R}_k} p ( \text{x},\mathcal{C}_k ) \text{dx}

p(correct)=k=1∑K?p(x∈Rk?,Ck?)=k=1∑K?∫Rk??p(x,Ck?)dx

1.5.2 最小化期望损失(Minimizing the expected loss)

书中举了一个对癌症病人分类的例子,我这里简单阐述一下。分类问题我们都会出现两种错误。一,给没有患癌症的病人错误地诊断为癌症,二、给患了癌症的病人诊断为健康。我们给出如下混淆矩阵: