tree_params = {'max_depth': [10, 20, 30],

'max_features': [30, 50, 64]}

tree_grid = GridSearchCV(tree, tree_params,

cv=5, n_jobs=-1, verbose=True)

tree_grid.fit(X_train, y_train)

7.查看交叉验证得到的最佳参数组合和相应的准确率

tree_grid.best_params_, tree_grid.best_score_

>>({'max_depth': 10, 'max_features': 50}, 准确率:0.8568203376968316)

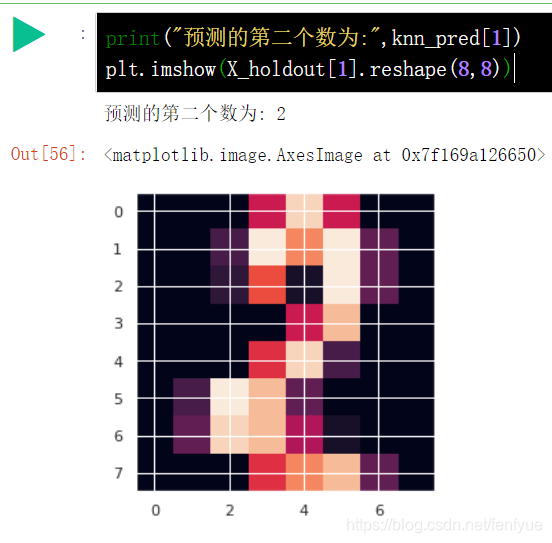

8.对KNN进行交叉验证

np.mean(cross_val_score(KNeighborsClassifier(

n_neighbors=1), X_train, y_train, cv=5))

>> 0.98648680282

7.在这一数据集上训练随机森林模型,在大多数数据集上,随机森林的效果比 KNN好

np.mean(cross_val_score(RandomForestClassifier(

random_state=17), X_train, y_train, cv=5))

>>0.9753456

但是从这个数据集中,随机森林的准确率不如KNN的高,

cs