import com.google.common.util.concurrent.RateLimiter;

import java.util.concurrent.TimeUnit;

public class GuavaRateLimiterDemo {

// 每秒 100 个令牌

private final RateLimiter rateLimiter = RateLimiter.create(100.0);

void doBusinessWithTryAcquire() {

boolean isPermit = rateLimiter.tryAcquire(500, TimeUnit.MILLISECONDS);

if (!isPermit) {

throw new RuntimeException("business overheated.");

}

// 继续操作用户业务

}

}

RateLimiter 不仅实现了令牌桶,还做了不少优化,可以满足不同场景的需求。

它支持「预热」warmupPeriod,tryAcquire 操作还支持立即计算返回,避免无效等待。

更多信息可以查看官方文档

[RateLimiter (Guava: Google Core Libraries for Java 19.0 API)])

https://guava.dev/releases/19.0/api/docs/index.html?com/google/common/util/concurrent/RateLimiter.html

缺点:

Guava RateLimiter(以及其他基于令牌桶算法的实现)缺点是只能针对单机,无法在分布式环境下面共享流量数据, 不适用于分布式服务。如果想使用的话,需要提前计算好每个示例负载均衡之后的流量阈值。

1.2.2 分布式限流

这一类的限流策略跟上面 API 路由网关模式的限流相似,同样是依赖配置中心管理,限流逻辑会配套服务化的框架完成。

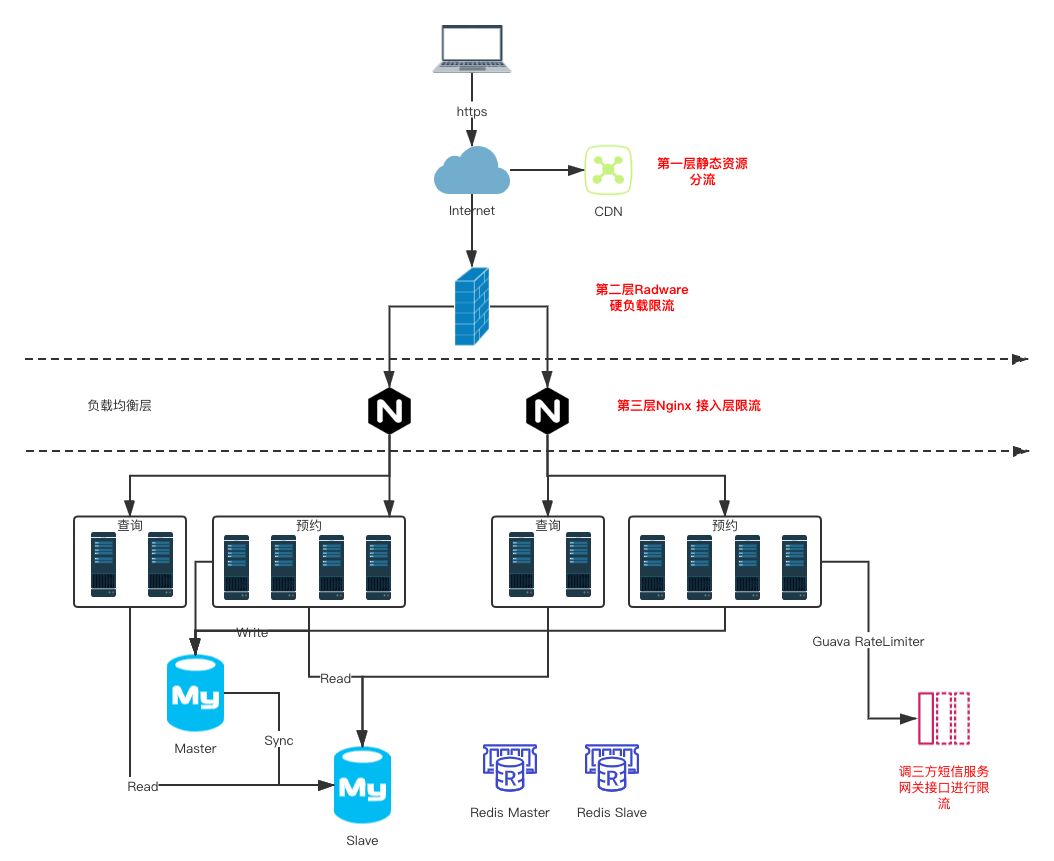

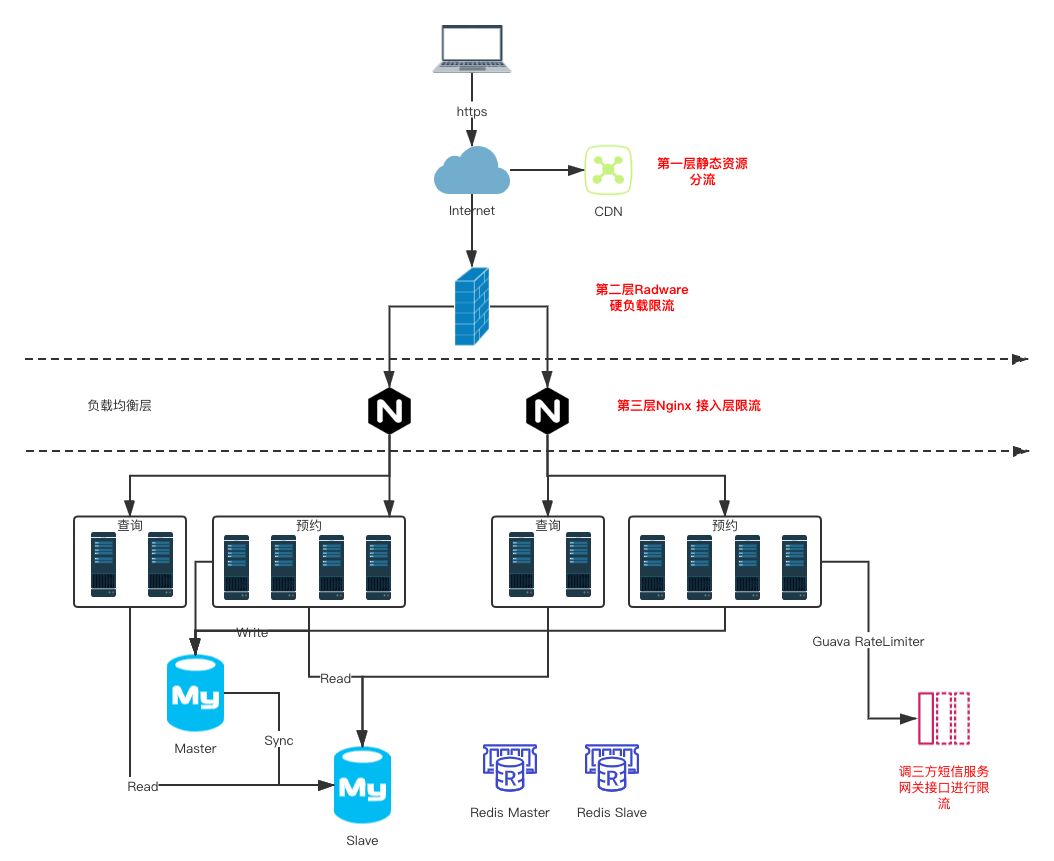

抗击疫情-某口罩预约项目限流实战

2.1 挑战

在抗疫期间,我们联合政府机构,外部的合作伙伴紧急上线了口罩预约的服务。由于在疫情期间,口罩预约是个大热点,在开放预约入口1分钟内,预约系统面临着每秒峰值XX w+的并发压力。针对这种秒杀预约的场景,联合ISV对业务系统进行了一系列的改造优化, 这里我们重点来看看该项目是怎么通过不断消减请求和限流来保障流量突增时系统的稳定性的。

2.2 实战

2.2.1 第一层: 合法性限流拦截

在口罩预约开放时间段内,用户执行的第一个动作是填写预约信息,并获取手机验证码进行提交。我们可以在这一层就将不合法的请求给拦截掉(刷单行为、是否已登录,预约渠道是否合法), 允许合法的用户访问到服务器。

- 预约时使用手机验证码,用来拉长用户访问时间。(输入验证码到提交预约整个过程可能需要五秒时间,降低访问峰值)

- 防火墙进行IP限制策略配置,防止不合法刷单行为。

- 非预约时间段内隐藏口罩预约入口页面。

2.2.2 第二层: 负载限流与服务限流

合法性限流只能限制无效、非法的请求。但对于口罩预约场景来说,仍然会有大量的合法有效请求进入系统。在项目上线前,协助ISV进行如下的分流和限流的优化。

- 查询和预约读写分离,分流数据库的压力。

- 静态资源请求上CDN,分担了总请求处理的压力。

- 扩容了Nginx代理层和后台服务集群,共同来负载请求压力。

- Nginx入层进行了第二层的限流熔断。(详细配置请参考上述文档中的Nginx限流方案)。

- 获取手机验证码会调用三方短信服务网关,在应用接口层面单独进行了限流。

通过上面介绍,相信大家对限流算法有了一定理解,那么像大厂在大促期间如何能抗住那么大的并发的呢? 大家别着急请关注我们明晚八点(2021/06/23)直播课程<抗住亿级高并发流量的微服务架构解决方案> 在本次课程中有深入讲解如何能抗住亿级高并发流量的系统设计.

直播地址:https://ke.qq.com/course/3454153?taid=11561948885071049&tuin=4ea50e8f

资料下载:http://106.75.108.26:8001/index?empid=8

资料共享群:601348591

cs